#Wie man in Minuten ein Klassifikationsmodell baut: Eine Pipeline zur Vorhersage des Zirrhose-Stadiums

📅 14.11.25 ⏱️ Lesedauer: 8 min

Der Aufbau von Machine-Learning-Modellen erforderte früher viel Code, Datenbereinigung und Debugging. Diese Zeiten sind vorbei. In diesem Tutorial bauen wir eine komplette Klassifikationspipeline zur Vorhersage von Zirrhose-Stadien mit echten Kaggle-Daten. Ganz ohne Code.

Am Ende hast du ein trainiertes Modell, Visualisierungen und eine funktionierende API. Los geht’s.

#⚡ Pro Tipp: Die 3-Klick-Abkürzung

Willst du das Setup überspringen? Unter der Chat-Bubble findest du fertige Templates. Klicke auf Classification Template oder Regression Template, lade deine Daten hoch und drücke „Run Flow“. Fertig.

Das Tutorial unten zeigt dir den gesamten Prozess von Grund auf, damit du jede Stufe verstehst. Sobald du das drauf hast, sind Templates dein schnellster Weg in die Produktion.

#Schritt 1: Daten von Kaggle auswählen

Als Erstes brauchen wir Daten. Zwei Wege.

Option A: Über die Chat-Oberfläche

Einfach schreiben: „Ich will Daten hinzufügen. Erstelle einen Node für mich“

Der Assistent setzt einen Data-Loader-Node auf dein Canvas. Klicke auf das Plus-Symbol, um den Upload zu öffnen.

Option B: Die KI alles erledigen lassen

Oder direkt schreiben: „Füge mir einen Open-Source-Datensatz über Zirrhose-Stadien hinzu“

Die KI sucht auf Kaggle, findet den Datensatz und fügt ihn automatisch ein.

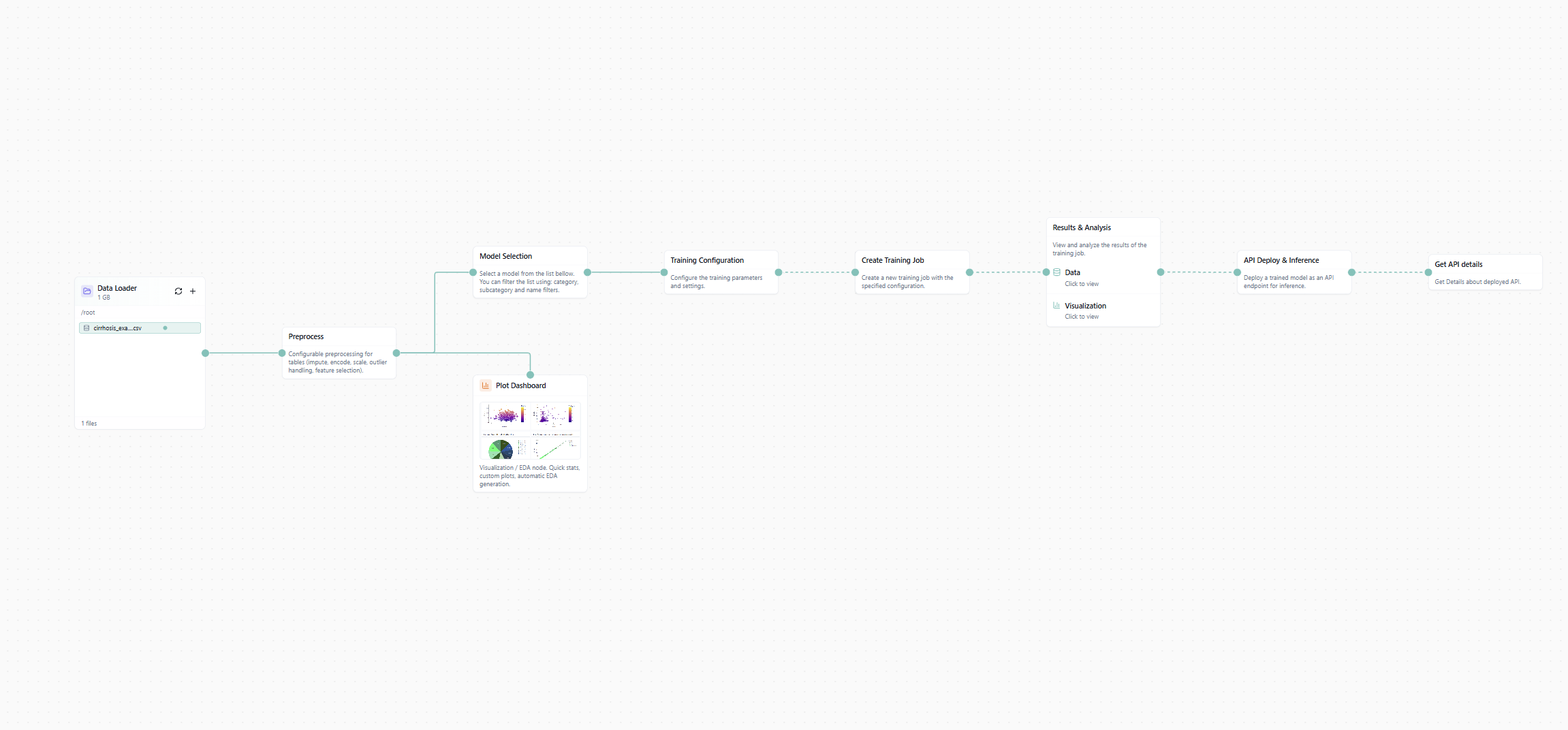

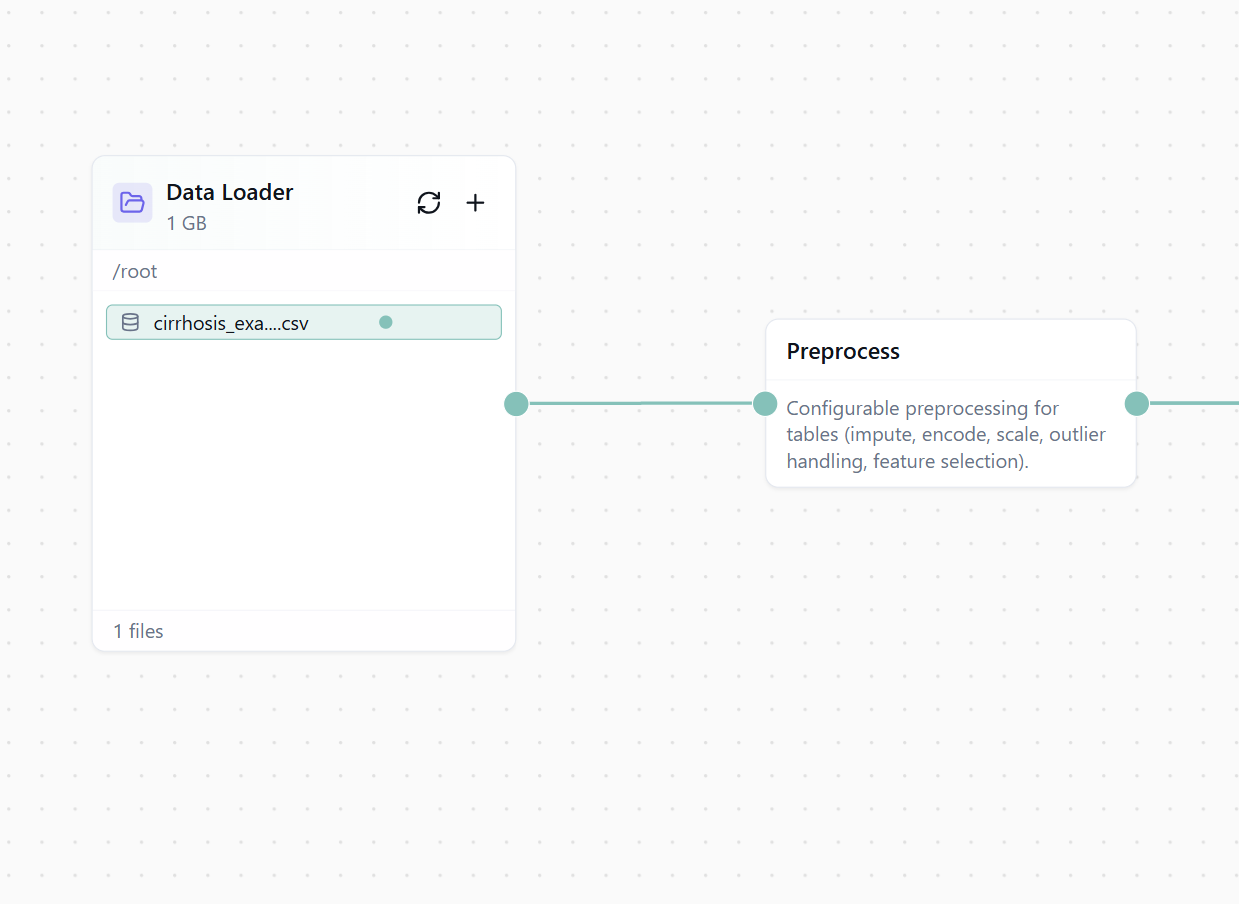

Figure 1: Das Workflow-Canvas mit geladenem Zirrhose-Datensatz.

Wenn du es manuell machst: Im Data-Loader zur Kaggle-Tab wechseln, „cirrhosis“ eingeben, Datensatz auswählen, fertig.

#Schritt 2: Deine Daten Processen

Rohdaten sind unordentlich. Wir bereinigen sie für das Training.

Füge einen Processing-Node ein. Dann im Chat:

„Passe die Processing-Settings an, damit wir die Daten für eine AI-Pipeline nutzen können“

Die KI richtet Cleaning ein, behandelt Missing Values, encodiert kategoriale Features und bereitet alles vor. Kein Pandas, kein NaN-Gefrickel.

Figure 2: Automatisierte Datenverarbeitung.

#Schritt 3: Mit KI-Empfohlenen Plots Visualisieren

Vor dem Training wollen wir Verständnis. Zeit für Plots.

Links in der Sidebar zum Library-Tab wechseln. Plot Dashboard auswählen, auf das Canvas ziehen und mit dem Processing-Node verbinden.

Dann: „Add Plots“ → „AI Suggestions“.

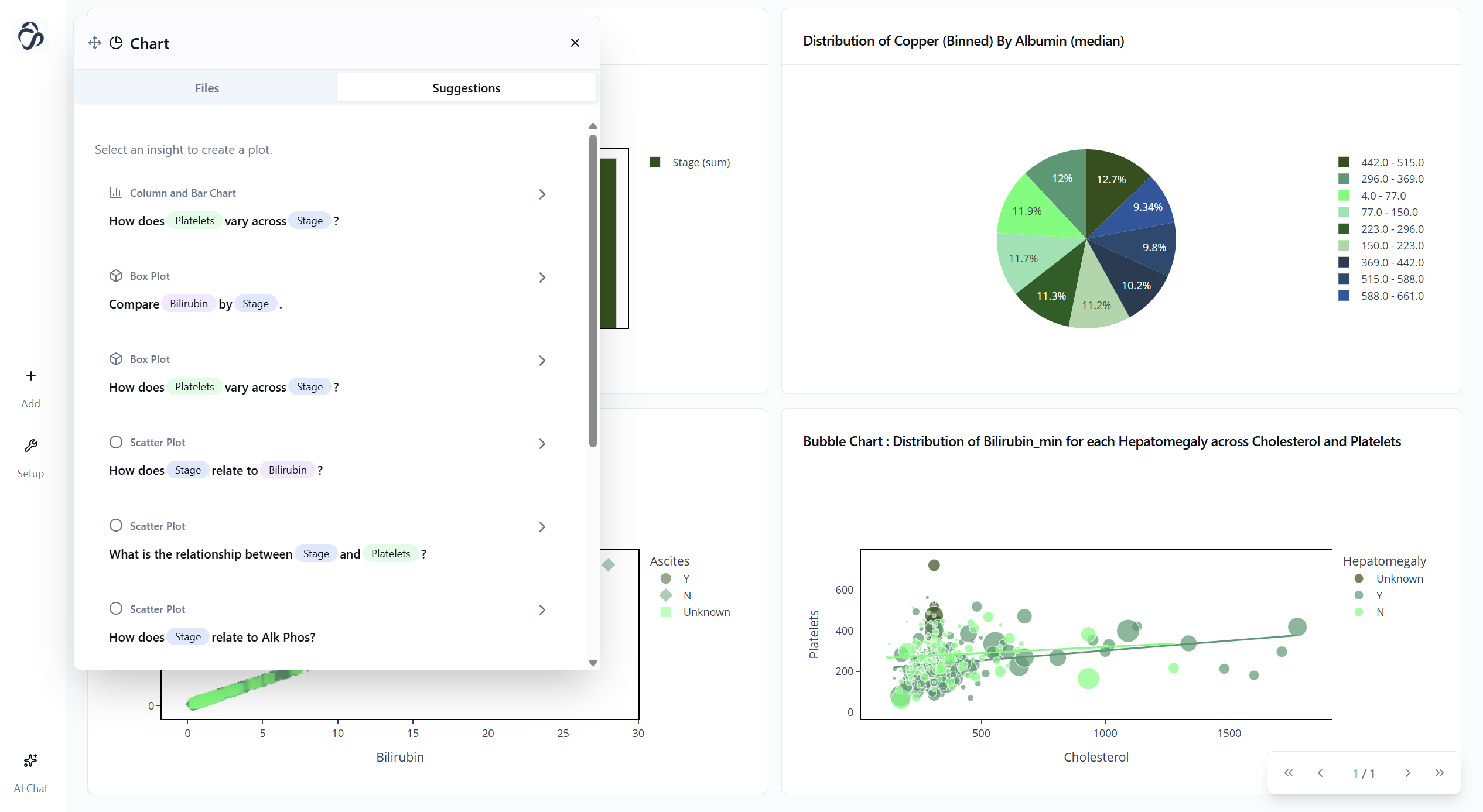

Die KI analysiert deine Daten und schlägt Visualisierungen als Fragen vor:

- „Wie ist die Verteilung der Zirrhose-Stadien?“

- „Wie korrelieren Bilirubinwerte mit dem Fortschritt?“

- „Welche Features zeigen die stärksten Beziehungen?“

Nimm, was sinnvoll aussieht.

Figure 3: KI-Plot-Vorschläge.

Figure 4: Dashboard mit KI-Insights.

Exportieren geht auch – Klick auf den Export-Button eines Charts.

#Schritt 4: Dein Modell Trainieren

Jetzt der Hauptteil: Klassifikationsmodell trainieren.

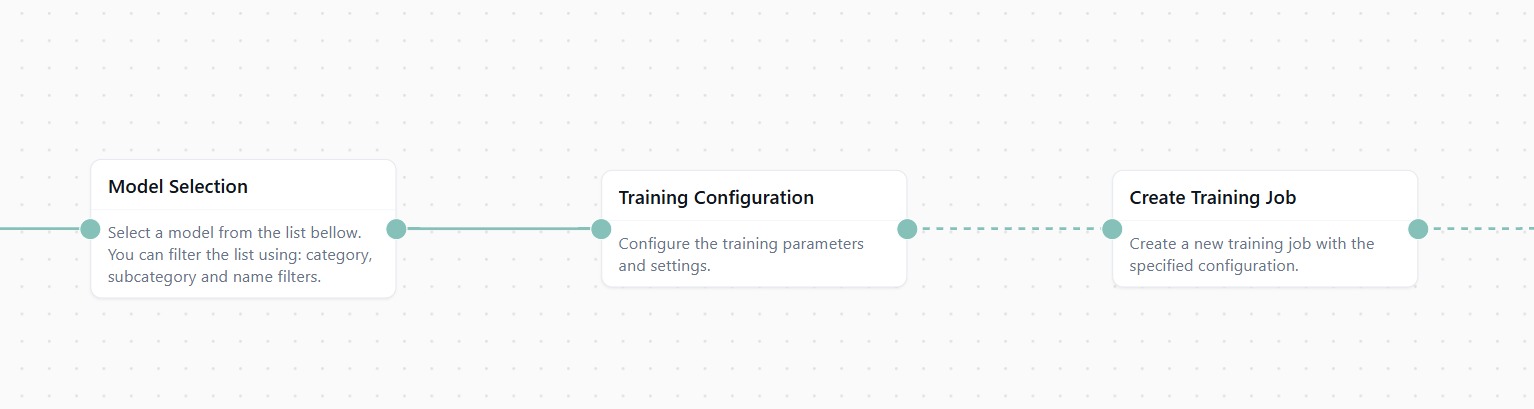

Drei Nodes hinzufügen:

- Model Selection

- Training Configuration

- Create Training Job

Dann im Chat: „Füge die Konfiguration für ein Klassifikationsmodell hinzu“

Die KI:

- wählt Algorithmus (Random Forest, XGBoost …)

- stellt Hyperparameter ein

- konfiguriert Train/Test-Split

- baut die Pipeline

Figure 5: Trainingspipeline bereit.

Alles verbinden: Data → Processing → Training

#Schritt 5: Ergebnisse & Insights

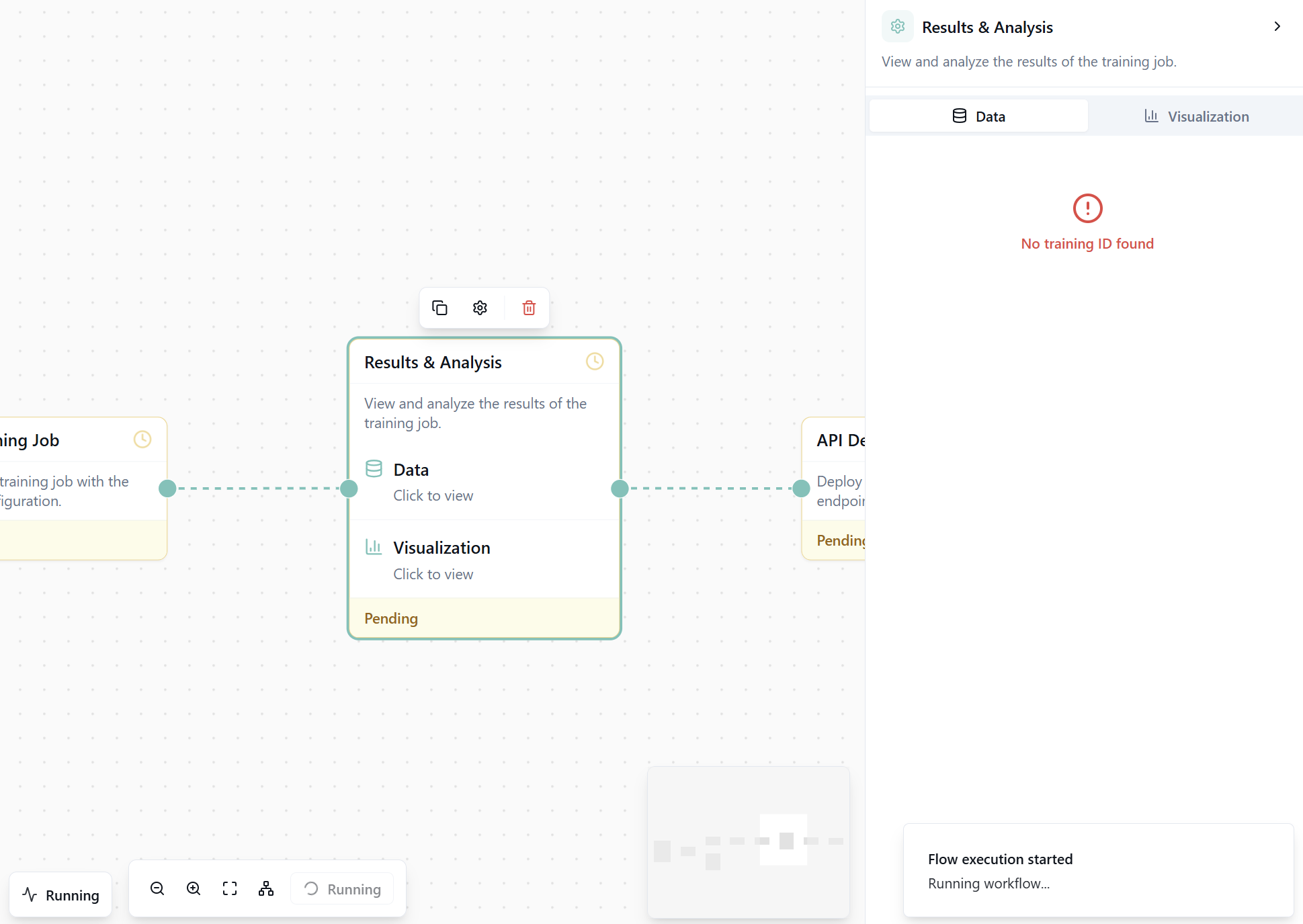

Dann einen Results & Analysis-Node hinzufügen. Er zeigt:

- Metriken (Accuracy, Precision, Recall, F1)

- Feature-Importance

- SHAP-Werte

Oben auf Run Flow klicken.

Figure 6: Vollständiger Workflow.

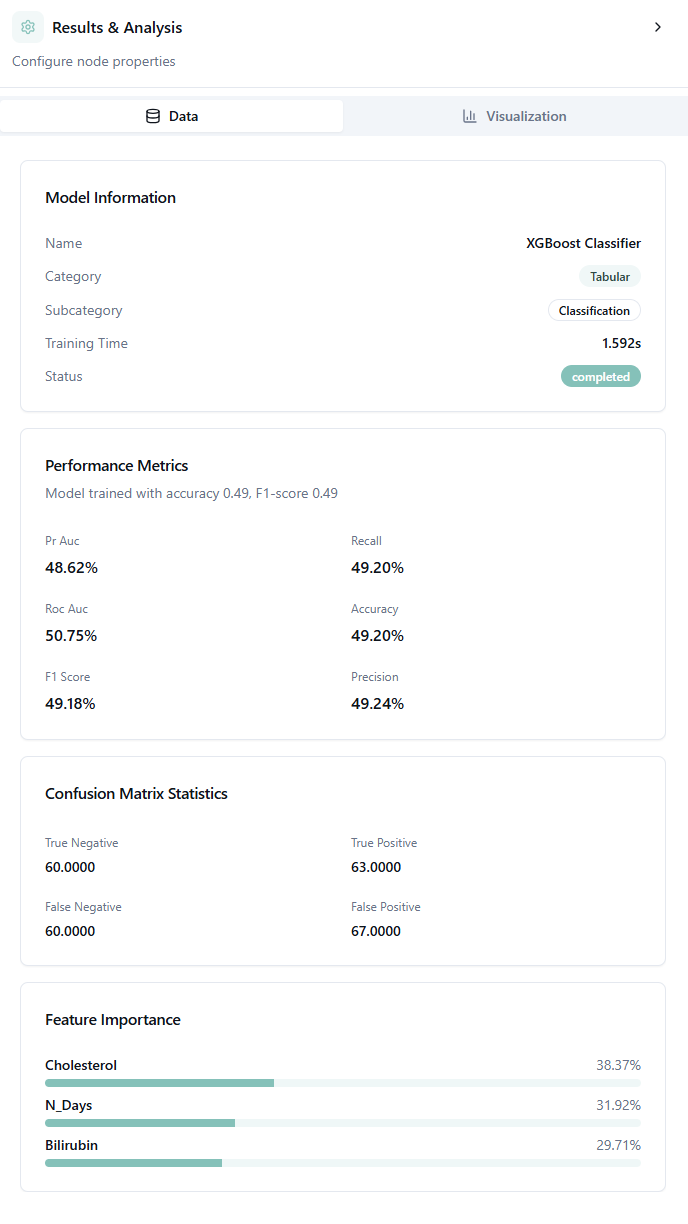

Nach der Ausführung: Results-Node öffnen.

Figure 7: Metriken & Confusion-Matrix.

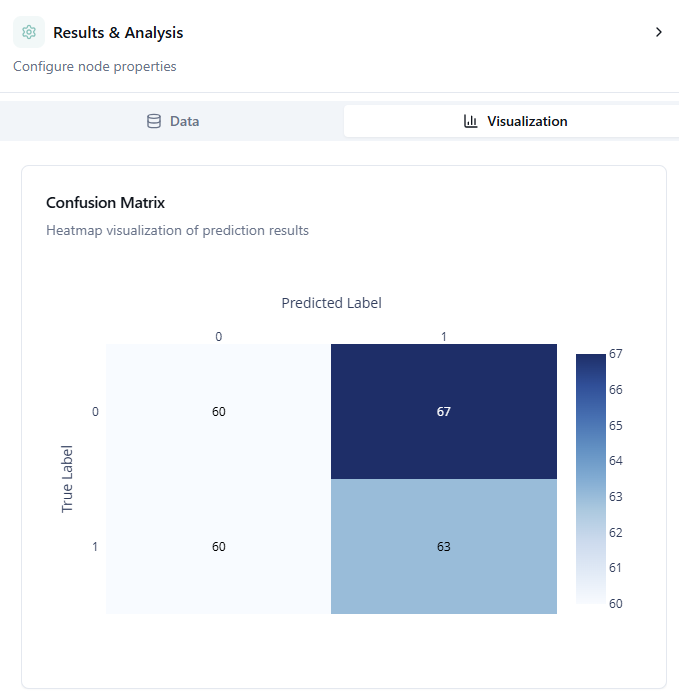

#Understanding the Confusion Matrix

Die Confusion-Matrix zeigt präzise, wo das Modell richtig liegt und wo es Fehler macht.

Lesart:

- Zeilen: echte Stadien

- Spalten: vorhergesagte

- Diagonale: korrekt

- Abseits der Diagonale: Fehler

Helle Felder außerhalb der Diagonale zeigen Fehlklassifikationen.

Gute Ergebnisse:

- helle Diagonale

- wenige Fehler daneben

- wenn Fehler: meist angrenzende Stadien statt extremer Sprünge

Einordnung: In der Medizin sind angrenzende Fehlklassifikationen tolerierbarer, extreme nicht.

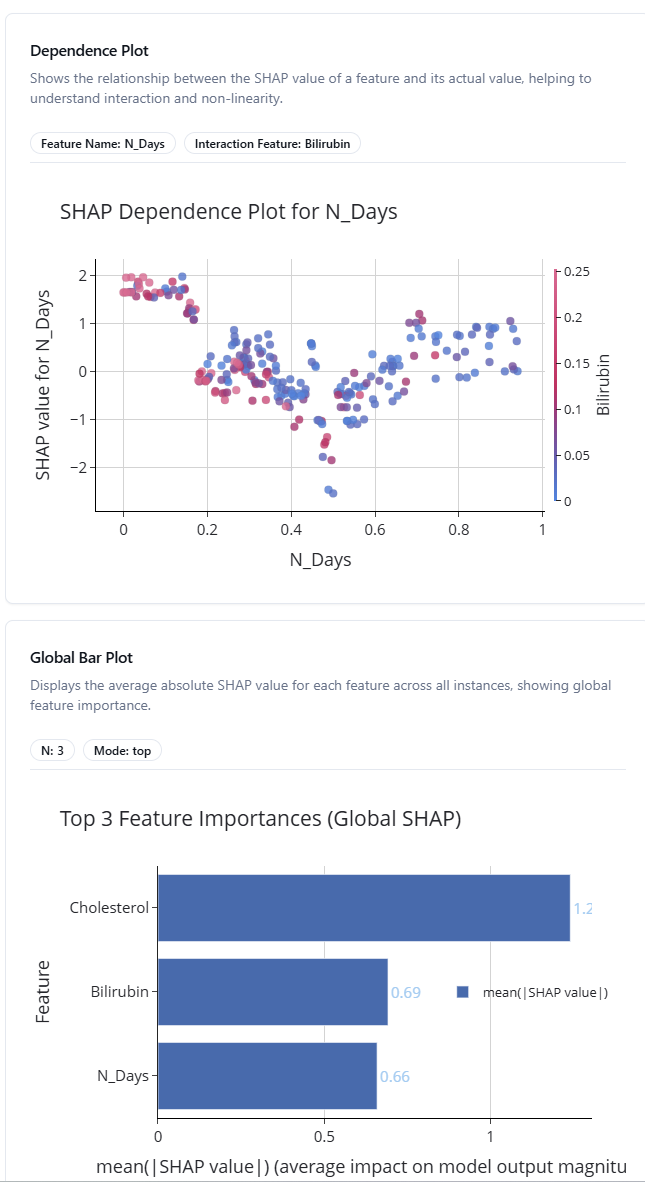

Figure 8: Globale Feature-Importance.

#Den "Global Bar Plot" verstehen

Dieses Diagramm zeigt, welche Features das Modell antreiben. Oben = wichtiger.

Hilft dir bei:

- medizinischer Interpretation

- Priorisierung von Messwerten

- Modellvereinfachung

Figure 9: SHAP-Dependence-Plot.

#SHAP Dependence Plots verstehen

Jeder Punkt = ein Patient. X-Achse: Featurewert Y-Achse: Einfluss auf die Vorhersage (SHAP) Farbe: Interaktion mit zweitem Feature

Steigender Verlauf = höhere Werte → höhere Vorhersagen.

Hilfreich für Validierung, neue Insights, medizinische Erklärbarkeit.

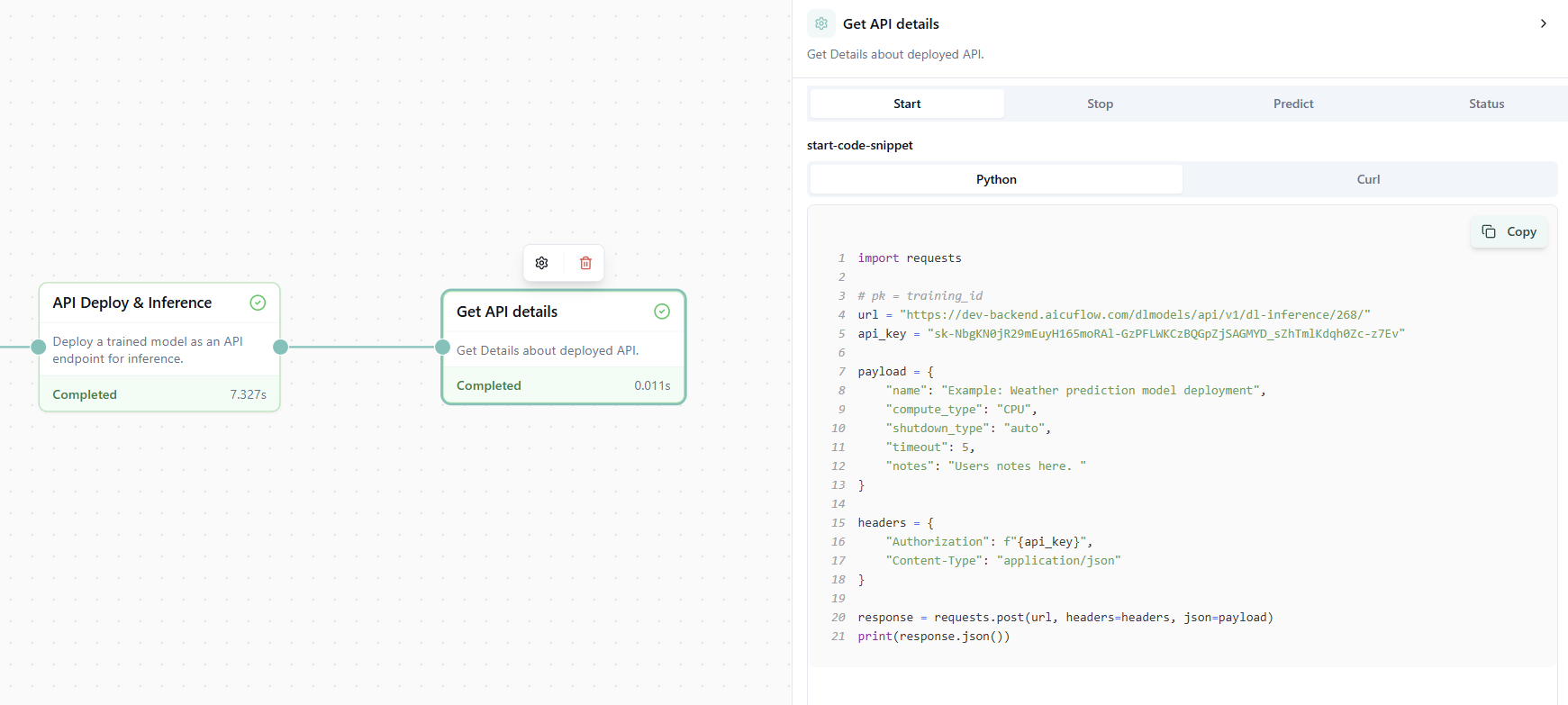

#Step 6: Deploying Your API

Das Modell steht. Jetzt soll es nutzbar werden.

Zwei Nodes:

- API Deploy & Inference

- API Details

Der Deploy-Node erstellt den Endpoint. Die Details zeigen:

- URL

- Tokens

- Beispielcode (Python, JS, cURL)

- Request/Response-Schema

Figure 10: API-Deployment-Details.

Jetzt kannst du das Modell in jeder App nutzen. Code kopieren und produktiv vorhersagen.

#Wrapping Up

In unter zehn Minuten hast du:

- echte Kaggle-Daten geladen

- sie automatisch verarbeitet

- Visualisierungen erzeugt

- ein Modell trainiert

- Ergebnisse analysiert

- eine produktionsfähige API deployed

Kein Code. Kein Debugging. Kein Setup.

Merke: Mit Templates erledigst du alles in drei Klicks: Template → Daten → Run Flow.

#References

[1] Cirrhosis Prediction Dataset. Kaggle. https://www.kaggle.com/datasets/fedesoriano/cirrhosis-prediction-dataset [2] SHAP. https://github.com/slundberg/shap